- Home /

- Publicaciones de patentes /

- MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN

Patente nacional por "MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN"

Este registro ha sido solicitado por

SEAT, S.A.

a través del representantePONTI & PARTNERS, S.L.P.

Contacto

- Estado: Vigente

- País:

- España

- Fecha solicitud:

- 05/08/2022

- Número solicitud:

-

P202230728

- Número publicación:

-

ES2961010

- Fecha de concesión:

-

- Inventores:

-

Persona física

- Datos del titular:

-

SEAT, S.A.

- Datos del representante:

-

PONTI & PARTNERS, S.L.P.

- Clasificación Internacional de Patentes:

- G01N 21/88,B21D 22/20

- Clasificación Internacional de Patentes de la publicación:

- G01N 21/88,B21D 22/20

- Fecha de vencimiento:

Quiero registrar una patente

Reivindicaciones:

+ ES-2961010_A11. Método de análisis de procesos de embutición para piezas de chapa, siendo los procesos de embutición del tipo que utilizan una matriz de deformación de piezas de chapa, comprendiendo el método de análisis las etapas de: a) teñir una pieza (1) de chapa a embutir con pintura de un color patrón, b) embutir la pieza (1) teñida y obtener una pieza (1) embutida mediante un proceso de embutición a analizar, c) seleccionar, por medio de un dispositivo de entrada de datos de un dispositivo portable, una representación virtual (2) de la pieza (1) embutida, almacenada en una unidad de memoria del dispositivo portable, estando el método de análisis caracterizado por que comprende una etapa de: d) captar, por medio de un dispositivo de captación de imágenes del dispositivo portable, la pieza (1) embutida y mostrarla a tiempo real por medio de un dispositivo de representación gráfica del dispositivo portable, e) representar en el dispositivo de representación gráfica la representación virtual (2) seleccionada de forma superpuesta a la pieza (1) embutida captada, por medio de realidad aumentada, f) desplazar manualmente el dispositivo portable hasta que la representación virtual (2) seleccionada coincida con la pieza (1) embutida mostrada a tiempo real, y g) analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la pieza (1) embutida. 2. Método de análisis según la reivindicación 1, el cual comprende, a la vez que se representa en el dispositivo de representación gráfica la representación virtual (2) de la pieza (1) embutida en la etapa e) , alterar la transparencia de dicha representación virtual (2) y/o proporcionar medios de ajuste para ajustar la transparencia de dicha representación virtual. 3. Método de análisis según cualquiera de las reivindicaciones anteriores, el cual comprende, después de la etapa f) , una etapa 6) de cotejar la coincidencia de la superposición entre la representación virtual (2) y la pieza (1) embutida mostrada en el dispositivo de representación gráfica. 4. Método de análisis según cualquiera de las reivindicaciones anteriores, donde la etapa g) comprende eliminar el entorno no perteneciente a la pieza (1) embutida mostrada en el dispositivo de representación gráfica. 5. Método de análisis según la reivindicación 5, donde eliminar el entorno no perteneciente a la pieza (1) embutida en la etapa g) comprende la aplicación de un filtro blanco/negro. 6. Método de análisis según cualquiera de las reivindicaciones anteriores, el cual comprende, después de la etapa f) , una etapa f2) de registrar al menos una imagen de la pieza (1) embutida captada por el dispositivo de representación gráfica, siendo dicha al menos una imagen la utilizada para llevar a cabo la etapa g) . 7. Método de análisis según la reivindicación 6, el cual comprende, previamente a la etapa g) , una etapa f3) de delimitar en la al menos una imagen de la pieza (1) embutida unas zonas de estudio (10) correspondientes a las zonas de la pieza (1) embutida a analizar en la etapa g) . 8. Método de análisis según la reivindicación 7, donde la etapa f3) de delimitar las zonas de estudio (10) comprende transferir, por medio de realidad aumentada, unos límites (20) que definen las zonas de estudio (10) de la representación virtual (2) de la pieza (1) embutida, estando dichos límites (20) previamente definidos, a la al menos una imagen captada de la pieza (1) embutida, tal que la etapa g) de analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la al menos una imagen captada de la pieza (1) embutida es ejecutada únicamente en las zonas de estudio (10) delimitada en la al menos una imagen captada de la pieza (1) embutida. 9. Método de análisis según la reivindicación 8, donde transferir unos límites (20) que definen las zonas de estudio (10) de la representación virtual (2) a la imagen captada de la pieza (1) embutida comprende superponer unas líneas de un color predefinido, diferente al color patrón, en la al menos una imagen captada de la pieza (1) embutida, por medio de realidad aumentada, correspondientes a dichos límites (20) que definen las zonas de estudio (10) de la representación virtual (2) de la pieza (1) embutida. 10. Método de análisis según la reivindicación 9, donde la etapa f3) de delimitar las zonas de estudio (10) comprende adicionalmente aplicar un filtro de detección del color predefinido y realizar una detección de dicho color predefinido pixel a pixel para determinar las líneas de color predefinido superpuestas por medio de realidad aumentada en la imagen captada de la pieza (1) embutida. 11. Método de análisis según cualquiera de las reivindicaciones anteriores, donde la etapa g) comprende realizar un barrido pixel a pixel para analizar el grado de similitud ntre la tonalidad de cada pixel y el color patrón almacenado en el dispositivo de memoria del dispositivo portable. 12. Método de análisis según la reivindicación 11, donde el color patrón almacenado en el dispositivo de memoria del dispositivo portable con el que analizar dicho grado de similitud comprende un rango de tonalidades. 13. Método de análisis según cualquiera de las reivindicaciones 11 o 12, que comprende una etapa adicional de calcular el porcentaje de embutición correcto en base al grado de similitud entre la tonalidad de cada pixel y el color patrón realizado durante el barrido pixel a pixel de la imagen captada de la pieza (1) embutida. 14. Dispositivo portable de análisis de procesos de embutición para piezas de chapa, que comprende: - una unidad de memoria configurada para almacenar representaciones virtuales de piezas embutidas, - un dispositivo de entrada de datos, configurado para permitir la selección de una de las representaciones virtuales almacenadas en la unidad de memoria, - un dispositivo de captación de imágenes configurado para captar imágenes, - un dispositivo de representación gráfica configurado para representar a tiempo real las imágenes captadas, - una unidad de control, operativamente conectada a la unidad de memoria, al dispositivo de entrada de datos, al dispositivo de captación de imágenes y al dispositivo de representación gráfica, donde la unidad de control está configurada para: o controlar el dispositivo de representación gráfica para representar por medio de realidad aumentada la representación virtual (2) seleccionada de forma superpuesta a una imagen captada de una pieza (1) embutida, o determinar una coincidencia en la superposición entre la representación virtual (2) seleccionada y la imagen captada de la pieza (1) embutida, ante los desplazamientos manuales del dispositivo portable, y o analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la imagen captada de la pieza (1) embutida.

Los productos y servicios protegidos por este registro son:

G01N 21/88 - B21D 22/20

Descripciones:

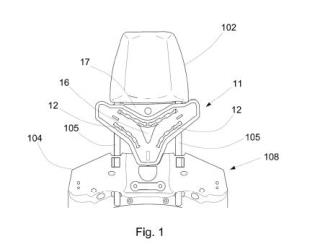

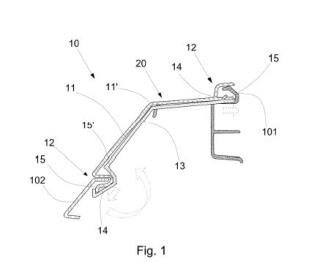

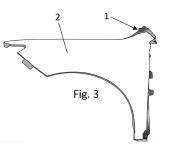

+ ES-2961010_A1 Método y dispositivo portable de análisis de procesos de embutición Sector de la técnica La presente invención concierne al sector de los procesos de embutición para piezas de chapa, en concreto al de analizar la calidad de los procesos de embutición. Estado de la técnica anterior Como es conocido, el proceso de obtención de una pieza metálica, partiendo de una lámina de chapa de un determinado espesor, puede tener diferentes etapas: embutir, conformar, engrapar, cortar, punzonar, doblar, etc. La estampación o embutición es el proceso principal de transformación de chapa utilizado más frecuentemente en la fabricación de piezas para el automóvil. Es el proceso de mayor importancia para la obtención de la forma general de la pieza. La embutición podría ser definida como la acción de transformación de una chapa plana en un cuerpo hueco. Las herramientas básicas que intervienen en una operación de embutir son el punzón, la matriz y el pisador. En primer lugar el formato se posiciona sobre la matriz. A continuación, el pisador cierra moviéndose contra la matriz hasta que el formato está en contacto total por ambos lados. Cuando el formato está completamente pisado, el pisador aplica una fuerza sobre la chapa que permite controlar la entrada del material durante el proceso de embutición. El punzón entonces, empuja la chapa contra la matriz, deformándola plásticamente y obteniendo la forma de la cavidad. Por lo tanto, aunque se hable de embutición de aquí en adelante, hay que entenderlo en términos genéricos de generar una determinada geometría a una lámina de chapa, donde puede existir otras etapas posteriores como un doblado o engrapado después de la embutición o estampación en sí. En la actualidad, la evaluación de los procesos de embutición se realiza por medio de observación de la pieza por parte de expertos en embutición, quienes otorgan un valor de adecuación de la pieza obtenida por embutición. Para realizar estas pruebas, la chapa se tiñe con pintura de un color. Durante el proceso de embutición, las matrices impactan y doblan la chapa, eliminando la pintura. El experto analiza si la pintura ha sido correctamente eliminada de la pieza; si hay blanco, significa que la matriz ha retirado por abrasión la pintura de dicha zona, consiguiendo una buena embutición. Por el contrario, i la pieza mantiene el color azul, la matriz no ha presionado correctamente dicha zona, por lo que la embutición no ha sido correcta. Sin embargo, es un procedimiento subjetivo. El documento CN112098428A divulga un sistema de reconocimiento de defectos basado en visión artificial para la fabricación de materiales en láminas, con el cual se identifican y clasifican los defectos. El sistema comprende una cámara con la que captura una imagen del producto y un software realiza un filtrado en la imagen para obtener una imagen de fondo y después recorrer cada píxel de la imagen para calcular la diferencia de escala de grises respecto a una referencia y clasificarlos mediante un algoritmo de visión artificial. Sin embargo, este tipo de sistemas son costosos de implementar y poco flexibles a la hora de analizar diferentes tipos de piezas, debido a la programación o entrenamiento previo que el sistema necesita para reconocer las piezas y su posición, por lo que estos sistemas no se utilizan para los análisis de los procesos de embutición previos a la fabricación en masa. Por tanto, existe la necesidad de un método de análisis de la calidad de procesos de embutición que sea realizado de forma automática y según unos criterios objetivos, a la vez que aporte flexibilidad para aplicarlo a diferentes tipos de piezas sin costes de programación o entrenamiento añadidos. Descripción de la invención La presente invención concierne, según un primer aspecto, a un método de análisis de procesos de embutición para piezas de chapa, siendo los procesos de embutición del tipo que utilizan una matriz de deformación de piezas de chapa. El método de análisis comprende las etapas de: a) teñir una pieza de chapa a embutir con pintura de un color patrón, preferiblemente azul, pudiendo realizarse dicha etapa por medios automáticos de pintura o por medios manuales, b) embutir la pieza teñida y obtener una pieza embutida mediante un proceso de embutición a analizar, eliminando la matriz al menos parte de la pintura en aquellas zonas en las que contacta con la pieza de chapa, correspondiendo dicho contacto a una correcta embutición cuando la eliminación de la pintura de la superficie de la pieza embutida es total, mientras que las zonas en las que permanece pintura en la pieza embutida corresponden a una embutición defectuosa, c) seleccionar, por medio de un dispositivo de entrada de datos del dispositivo portable, una representación virtual de una pieza patrón relativa a la pieza mbutida, almacenada en una unidad de memoria del dispositivo portable. Dicha selección puede realizarse, por ejemplo, seleccionando de forma manual una de entre una pluralidad de representaciones virtuales de la pieza embutida almacenadas a través de una interfaz del dispositivo portable. A diferencia de los divulgados en el estado de la técnica, el presente método de análisis se caracteriza por que comprende las etapas de: d) captar, por medio de un dispositivo de captación de imágenes del dispositivo portable, la pieza embutida y mostrarla a tiempo real por medio de un dispositivo de representación gráfica (por ejemplo, una pantalla) del dispositivo portable, e) representar en el dispositivo de representación gráfica la representación virtual seleccionada de forma superpuesta a la pieza embutida captada, por medio de realidad aumentada, por ejemplo, representándose la representación virtual de forma centrada en el dispositivo de representación gráfica, f) desplazar manualmente el dispositivo portable hasta que la representación virtual superpuesta coincida con la pieza embutida mostrada a tiempo real, g) analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la pieza embutida. El presente método de análisis combina la realidad aumentada de un dispositivo portable con algoritmos de inteligencia artificial, es decir, utiliza una forma eficaz y flexible para captar diferentes piezas embutidas y hacerlas coincidir con su representación virtual, lo cual permite ampliar fácilmente el método de análisis a nuevos procesos de embutición, a la vez que utiliza algoritmos de inteligencia artificial para reconocer si la tonalidad del color a identificar coincide con la tonalidad de la pintura que se acepta como correcta. Ambas tecnologías cooperan con el fin de reducir el coste computacional y simplificar el proceso de analizar la calidad de procesos de embutición, al no necesitar una programación de reconocimiento y discretización de las piezas embutidas. De esta manera se consigue acotar y cuantificar de manera precisa la cantidad y propiedades visuales de la pintura restante en las piezas embutidas y mantener un histórico de datos de embutición que permite realizar análisis y posibles predicciones futuras de los procesos. En una posible realización, el método comprende, a la vez que se representa en el dispositivo de representación gráfica la representación virtual, alterar la transparencia de dicha representación virtual y/o proporcionar medios de ajuste para ajustar la transparencia de dicha representación virtual, de forma que el operario puede cotejar visualmente la coincidencia en 3D de la superposición de la pieza embutida y la epresentación virtual. Así, se permite la representación simultánea tanto de la representación virtual de la pieza embutida como de la pieza embutida a analizar, a través de una alteración de los parámetros de representación gráfica de la representación virtual de la pieza embutida. Los medios de ajuste pueden ser, por ejemplo, una barra virtual situada en un lateral de la pantalla, la cual es desplazable verticalmente y la transparencia cambia en función de la posición de la barra. Otro ejemplo sería mostrar en pantalla un botón "+" y un botón "-"para aumentar o disminuir la transparencia. En una posible realización, el método comprende, después de la etapa f) , una etapa 0) de cotejar la coincidencia de la superposición entre la representación virtual y la pieza embutida mostrada en el dispositivo de representación gráfica, tanto del perfil exterior como de los volúmenes o superficies, puesto que la cámara podría estar inclinada respecto a la ortogonal de la pieza embutida y sus superficies no ser coincidentes con las de la representación virtual. Esta etapa la lleva a cabo el software mediante algoritmos de inteligencia artificial. De forma preferente, el software emite un aviso cuando se ha realizado el casamiento entre volúmenes o superficies. Según una realización preferente, con el fin de minimizar los recursos de procesamiento, la representación virtual de la pieza embutida es únicamente en dos dimensiones, requiriéndose que se produzca un casamiento entre dicha superficie de la representación virtual y la pieza embutida captada. Una vez realizado dicho casamiento, el software recupera la geometría tridimensional de la pieza embutida seleccionada de la unidad de memoria del dispositivo portable, con el fin de poder realizar el análisis del grado de pintura restante en las diferentes perspectivas o enfoques de la pieza embutida. Se simplifica de este modo la etapa de casamiento, vinculando dicha etapa ejecutada por las herramientas de realidad aumentada a un casamiento entre geometrías en dos dimensiones. Alternativamente, dicho casamiento o comparación de la coincidencia se realiza con información tridimensional, tanto de la representación virtual de la pieza embutida como de la pieza embutida a estudio representada, de manera que se facilita la existencia de dicha coincidencia. En una posible realización, el método comprende, preferiblemente después de la etapa f) y comprenda o no la etapa 6) , una etapa f2) de registrar al menos una imagen de la pieza embutida captada por el dispositivo de representación gráfica y almacenarla en la unidad de memoria del dispositivo portable, siendo esta la al menos una imagen utilizada para llevar a cabo la etapa g) . Nuevamente con el objetivo de reducir los recursos de procesamiento del software requeridos, el análisis mediante algoritmos de inteligencia artificial del grado de pintura restante en la pieza embutida se realiza sobre imágenes oncretas captadas por el usuario a través del dispositivo de captación de imágenes del dispositivo portable, en lugar de un procesamiento y análisis de grado de pintura restante a tiempo real de la pieza embutida captada por dicho dispositivo. Opcionalmente, la etapa g) comprende eliminar el entorno no perteneciente a la pieza embutida en la al menos una imagen de la pieza embutida, lo que permite determinar exactamente el volumen o la superficie de la pieza embutida. Por ejemplo, la etapa g) comprende la aplicación de un filtro blanco/negro a la al menos una imagen de la pieza embutida. En una realización preferente, el método comprende, previamente a la etapa g) , una etapa f3) de delimitar en la pieza embutida unas zonas de estudio correspondientes a las zonas a analizar en la etapa g) . En concreto, las zonas de principal interés para estudiar la calidad de embutición corresponden con las zonas perimetrales de la pieza embutida. De este modo, la etapa g) de análisis de centra en dichas zonas de mayor interés. En una implementación preferente, la etapa f3) de delimitar las zonas de estudio comprende transferir, por medio de realidad aumentada, unos límites que definen dichas zonas de estudio a la al menos una imagen de la pieza embutida captada, estando dichos límites previamente definidos en la representación virtual. De este modo, las librerías de realidad aumentada reconocen las zonas concretas de estudio (definidas por los límites previamente definidos) de la al menos una imagen captada de la pieza embutida, por lo que los algoritmos de inteligencia artificial aplicados para analizar el grado de pintura restante en la pieza embutida son aplicados únicamente sobre dichas zonas de estudio delimitadas por la realidad aumentada. Opcionalmente, en la etapa f3) , dichos límites pueden afinarse o modificarse manualmente marcando táctilmente dichas zonas en el dispositivo de representación gráfica o pantalla (por ejemplo, las zonas señaladas manualmente pueden ser zonas a extraer de las zonas de estudio) . Gracias a ello, la etapa g) de analizar mediante algoritmos de inteligencia artificial el grado de pintura restante en la pieza embutida es ejecutada únicamente en las zonas de estudio delimitada de la pieza embutida. Con ello, en una misma etapa, se aplica la realidad aumentada y los algoritmos de visión artificial para reducir el coste computacional del análisis de la pieza embutida. Por ejemplo, la etapa de transferir dichos límites comprende superponer unas líneas de un color predefinido, diferente al color patrón, en la al menos una imagen captada de la pieza embutida, por medio de realidad aumentada. En este caso y de forma preferible, la etapa f3) de delimitar las zonas de estudio comprende adicionalmente aplicar un filtro de etección del color predefinido y realizar una detección de dicho color predefinido pixel a pixel para determinar las líneas de color predefinido superpuestas por medio de realidad aumentada en la imagen captada de la pieza embutida. De este modo se delimitan las zonas de estudio a analizar. En una posible realización, la etapa g) comprende realizar un barrido pixel a pixel para analizar el grado de similitud entre la tonalidad de cada pixel y el color patrón almacenado en el dispositivo de memoria del dispositivo portable. De forma preferente, el color patrón almacenado en el dispositivo de memoria del dispositivo portable con el que analizar dicho grado de similitud comprende un rango de tonalidades, preferiblemente calibrable, ya sea proporcionando medios de calibración para calibrar a mano dicho rango de similitud o calibrándolo el software de forma automática. De forma opcional, el método comprende una etapa adicional de calcular el porcentaje de embutición correcto en base al grado de similitud entre la tonalidad de cada pixel y el color patrón realizado durante el barrido pixel a pixel de la imagen captada de la pieza embutida. Dicho cálculo se puede llevar a cabo por porciones de la pieza embutida, dividiendo la imagen de la pieza embutida en una cuadrícula. De la misma forma, el dispositivo portable puede mostrar por pantalla el resultado obtenido para cada porción de la cuadrícula. Un segundo aspecto de la presente invención consiste en un dispositivo portable de análisis de procesos de embutición para piezas de chapa, el cual comprende: - una unidad de memoria configurada para almacenar representaciones virtuales de piezas embutidas, - un dispositivo de entrada de datos, configurado para permitir la selección de una de las representaciones virtuales almacenadas en la unidad de memoria, - un dispositivo de captación de imágenes configurado para captar imágenes, - un dispositivo de representación gráfica configurado para representar a tiempo real las imágenes captadas, - una unidad de control, operativamente conectada a la unidad de memoria, al dispositivo de entrada de datos, al dispositivo de captación de imágenes y al dispositivo de representación gráfica, donde la unidad de control está configurada para: o controlar el dispositivo de representación gráfica para representar por medio de realidad aumentada la representación virtual seleccionada de forma superpuesta a una imagen captada de una pieza embutida, o determinar una coincidencia en la superposición entre la representación virtual seleccionada y la imagen captada de la pieza embutida, ante los desplazamientos manuales del dispositivo portable, y o analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la imagen captada de la pieza embutida. El objetivo de la presente invención es implementar en un dispositivo portable, por lo tanto, desplazable por parte del usuario para poder analizar en cualquier situación, ubicación y estado la calidad de embutición de una pieza embutida, donde el dispositivo portable tenga un sistema de captación de imágenes, un software que combine Realidad Aumentada con Visión Artificial, buscando que el análisis de calidad de la embutición sea realizado de forma automática y según unos criterios objetivos. Breve descripción de los dibujos Las anteriores y otras ventajas y características se comprenderán más plenamente a partir de la siguiente descripción detallada de unos ejemplos de realización con referencia a los dibujos adjuntos, que deben tomarse a título ilustrativo y no limitativo, en los que: - La fig. 1 ilustra un diagrama de bloques que muestra el orden de las etapas de un ejemplo de realización del presente método de análisis de procesos de embutición. - La fig. 2 ilustra una imagen de ejemplo reproducida por un dispositivo de representación gráfica del dispositivo portable usado durante la etapa e) del presente procedimiento. - La fig. 3 ilustra otra imagen de ejemplo consistente en la representación virtual superpuesta de forma coincidente con la pieza embutida al llevar a cabo la etapa e) del presente procedimiento. - La fig. 4 ilustra un ejemplo de aplicación de la etapa f3) , en la que se muestran los límites predefinidos en la representación virtual a transferir a la imagen captada de la pieza embutida por medio de realidad aumentada. - La fig. 5 ilustra una imagen que ejemplifica la aplicación en la etapa f3) de un filtro de detección del color predefinido para determinar las zonas de estudio. - La fig. 6 ilustra una imagen de ejemplo que muestra el cálculo del porcentaje de embutición correcto en base al grado de similitud entre la tonalidad de cada pixel de la pieza embutida y el color patrón. Descripción detallada de unos ejemplos de realización En la figura 1 se encuentra ilustrado un diagrama de bloques que muestra el orden de las etapas de un ejemplo de realización del presente método de análisis de procesos de embutición para piezas de chapa. Esta realización comprende las etapas de: a) teñir una pieza (1) de chapa a embutir con pintura de un color patrón, siendo dicha etapa ejecutada de forma manual por parte de un operario o de forma automática por parte de un equipo de pintura, b) embutir la pieza (1) teñida y obtener una pieza (1) embutida mediante un proceso de embutición, c) seleccionar, por medio de un dispositivo de entrada de datos de un dispositivo portable, una representación virtual (2) de la pieza (1) embutida, almacenada en una unidad de memoria del dispositivo portable, d) captar, por medio de un dispositivo de captación de imágenes del dispositivo portable, la pieza (1) embutida y mostrarla a tiempo real por medio de un dispositivo de representación gráfica del dispositivo portable, e) representar en el dispositivo de representación gráfica la representación virtual (2) seleccionada de forma superpuesta a la pieza (1) embutida captada, por medio de realidad aumentada, f) desplazar manualmente el dispositivo portable hasta que la representación virtual (2) seleccionada coincida con la pieza (1) embutida mostrada a tiempo real, 0) cotejar la coincidencia de la superposición entre la representación virtual (2) y la pieza (1) embutida mostrada en el dispositivo de representación gráfica, f2) registrar y almacenar en la unidad de memoria del dispositivo portable al menos una imagen de la pieza (1) embutida, una vez se ha determinado una coincidencia en la superposición entre la representación virtual (2) y la pieza (1) embutida, f3) delimitar en la al menos imagen registrada de la pieza (1) embutida unas zonas de estudio (10) correspondientes a las zonas a analizar en la etapa g) , en base a unos límites (20) que definen dichas zonas de estudio (10) , los cuales se encuentran previamente definidos en la representación virtual (2) , g) analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en las zonas de estudio (10) de la pieza (1) embutida. La fig. 2 ilustra una imagen de ejemplo reproducida por un dispositivo de representación gráfica del dispositivo portable usado durante la etapa e) del presente procedimiento. Esta imagen de la fig. 2 muestra la representación virtual (2) relativa a una pieza (1) embutida de ejemplo, así como una porción de dicha pieza (1) embutida captada a tiempo eal con el dispositivo de captación de imágenes del dispositivo portable. Se observa como la pieza (1) embutida no está comprendida totalmente en el campo de visión del dispositivo de captación de imágenes del dispositivo portable, por lo que aparece cortada. Por su lado, se observa como la representación virtual (2) previamente seleccionada por el usuario relativa a la pieza (1) embutida aparece representada en el centro del dispositivo de representación gráfica. Dicha representación está además alterada en cuanto a su transparencia, permitiendo al usuario poder observar simultáneamente tanto dicha representación virtual (2) como la imagen a tiempo real captada de la pieza (1) embutida. En la fig. 3 se ha ilustrado otra imagen de ejemplo reproducida por el dispositivo de representación gráfica en el momento en que el usuario, moviendo el dispositivo portable, ha hecho coincidir de forma superpuesta la representación virtual (2) con la pieza (1) embutida durante la etapa e) del presente procedimiento. Por medio de la representación en realidad aumentada se permite que exista una coincidencia entre ambas representaciones de la pieza. La fig. 4 ilustra un ejemplo de aplicación de la etapa f3) , en la que se muestran los límites (20) predefinidos de la representación virtual (2) a transferir a la imagen de la pieza (1) embutida por medio de realidad aumentada, los cuales definen las zonas de estudio (10) a analizar de la pieza (1) embutida en la etapa g) , a la vez que se muestran las zonas señaladas manualmente (21) que deben ser extraídas de las zonas de estudio (10) . En consecuencia, una vez determinada la coincidencia entre la pieza (1) embutida y su representación virtual (2) , la unidad de control realiza una captación de diferentes imágenes de la pieza (1) embutida por medio del dispositivo de captación de imágenes. Dichas imágenes son almacenadas en la unidad de memoria. La unidad de control recupera la información tridimensional de la pieza a estudio almacenada en la unidad de memoria del dispositivo portable con el fin de establecer una coincidencia entre las diferentes perspectivas de las diferentes imágenes de la pieza (1) embutida captadas. Por medio de las correspondientes librerías de realidad aumentada, se establecen unos límites (20) que definen unas zonas de estudio (10) correspondientes a las zonas a analizar en la etapa g) . Dicha delimitación de las zonas de estudio (10) permite que el análisis por visión computacional se ejecute únicamente sobre dichas zonas de estudio En la fig. 5 se ha ilustrado una imagen que ejemplifica la aplicación de un filtro de detección de un color predefinido para determinar dichas zonas de estudio (10) al llevar a cabo la etapa f3) . Una vez determinadas dichas zonas de estudio (10) , se aplican unos algoritmos de visión artificial con el fin de determinar las áreas de las zonas de estudio (10) de color azul, así como un rango de similitud a ese color azul patrón, por medio de filtros de color azul. La fig. 6 ilustra imagen de ejemplo que muestra el cálculo del porcentaje de embutición correcto de la pieza (1) embutida para las diferentes porciones (31) de una cuadrícula (3) , en base al grado de similitud entre la tonalidad de cada pixel de la pieza (1) embutida y el color patrón, obtenido durante el barrido pixel a pixel de la imagen captada de la pieza (1) embutida llevado a cabo en la etapa g) . Así, la unidad de control crea un reporte indicando el porcentaje correcto de embutición total, así como porcentajes parciales dividiendo la superficie de la pieza (1) embutida en porciones según el tamaño de la pieza a analizar, por ejemplo, para el ejemplo en cuestión, una cuadrícula 9x5.

Publicaciones:

ES2961010 (07/03/2024) - A1 Solicitud de patente con informe sobre el estado de la técnica

Eventos:

En fecha 05/08/2022 se realizó Registro Instancia de Solicitud

En fecha 08/08/2022 se realizó Admisión a Trámite

En fecha 08/08/2022 se realizó 1001P_Comunicación Admisión a Trámite

En fecha 16/09/2022 se realizó Superado examen de oficio

En fecha 16/12/2022 se realizó Realizado IET

En fecha 23/12/2022 se realizó 1109P_Comunicación Traslado del IET

En fecha 07/03/2024 se realizó Publicación Solicitud

En fecha 07/03/2024 se realizó Publicación Folleto Solicitud con IET (A1)

En fecha 19/04/2024 se realizó PETEX_Petición de examen sustantivo

Pagos:

05/08/2022 - Pago Tasas IET

+ ES-2961010_A11. Método de análisis de procesos de embutición para piezas de chapa, siendo los procesos de embutición del tipo que utilizan una matriz de deformación de piezas de chapa, comprendiendo el método de análisis las etapas de: a) teñir una pieza (1) de chapa a embutir con pintura de un color patrón, b) embutir la pieza (1) teñida y obtener una pieza (1) embutida mediante un proceso de embutición a analizar, c) seleccionar, por medio de un dispositivo de entrada de datos de un dispositivo portable, una representación virtual (2) de la pieza (1) embutida, almacenada en una unidad de memoria del dispositivo portable, estando el método de análisis caracterizado por que comprende una etapa de: d) captar, por medio de un dispositivo de captación de imágenes del dispositivo portable, la pieza (1) embutida y mostrarla a tiempo real por medio de un dispositivo de representación gráfica del dispositivo portable, e) representar en el dispositivo de representación gráfica la representación virtual (2) seleccionada de forma superpuesta a la pieza (1) embutida captada, por medio de realidad aumentada, f) desplazar manualmente el dispositivo portable hasta que la representación virtual (2) seleccionada coincida con la pieza (1) embutida mostrada a tiempo real, y g) analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la pieza (1) embutida. 2. Método de análisis según la reivindicación 1, el cual comprende, a la vez que se representa en el dispositivo de representación gráfica la representación virtual (2) de la pieza (1) embutida en la etapa e) , alterar la transparencia de dicha representación virtual (2) y/o proporcionar medios de ajuste para ajustar la transparencia de dicha representación virtual. 3. Método de análisis según cualquiera de las reivindicaciones anteriores, el cual comprende, después de la etapa f) , una etapa 6) de cotejar la coincidencia de la superposición entre la representación virtual (2) y la pieza (1) embutida mostrada en el dispositivo de representación gráfica. 4. Método de análisis según cualquiera de las reivindicaciones anteriores, donde la etapa g) comprende eliminar el entorno no perteneciente a la pieza (1) embutida mostrada en el dispositivo de representación gráfica. 5. Método de análisis según la reivindicación 5, donde eliminar el entorno no perteneciente a la pieza (1) embutida en la etapa g) comprende la aplicación de un filtro blanco/negro. 6. Método de análisis según cualquiera de las reivindicaciones anteriores, el cual comprende, después de la etapa f) , una etapa f2) de registrar al menos una imagen de la pieza (1) embutida captada por el dispositivo de representación gráfica, siendo dicha al menos una imagen la utilizada para llevar a cabo la etapa g) . 7. Método de análisis según la reivindicación 6, el cual comprende, previamente a la etapa g) , una etapa f3) de delimitar en la al menos una imagen de la pieza (1) embutida unas zonas de estudio (10) correspondientes a las zonas de la pieza (1) embutida a analizar en la etapa g) . 8. Método de análisis según la reivindicación 7, donde la etapa f3) de delimitar las zonas de estudio (10) comprende transferir, por medio de realidad aumentada, unos límites (20) que definen las zonas de estudio (10) de la representación virtual (2) de la pieza (1) embutida, estando dichos límites (20) previamente definidos, a la al menos una imagen captada de la pieza (1) embutida, tal que la etapa g) de analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la al menos una imagen captada de la pieza (1) embutida es ejecutada únicamente en las zonas de estudio (10) delimitada en la al menos una imagen captada de la pieza (1) embutida. 9. Método de análisis según la reivindicación 8, donde transferir unos límites (20) que definen las zonas de estudio (10) de la representación virtual (2) a la imagen captada de la pieza (1) embutida comprende superponer unas líneas de un color predefinido, diferente al color patrón, en la al menos una imagen captada de la pieza (1) embutida, por medio de realidad aumentada, correspondientes a dichos límites (20) que definen las zonas de estudio (10) de la representación virtual (2) de la pieza (1) embutida. 10. Método de análisis según la reivindicación 9, donde la etapa f3) de delimitar las zonas de estudio (10) comprende adicionalmente aplicar un filtro de detección del color predefinido y realizar una detección de dicho color predefinido pixel a pixel para determinar las líneas de color predefinido superpuestas por medio de realidad aumentada en la imagen captada de la pieza (1) embutida. 11. Método de análisis según cualquiera de las reivindicaciones anteriores, donde la etapa g) comprende realizar un barrido pixel a pixel para analizar el grado de similitud ntre la tonalidad de cada pixel y el color patrón almacenado en el dispositivo de memoria del dispositivo portable. 12. Método de análisis según la reivindicación 11, donde el color patrón almacenado en el dispositivo de memoria del dispositivo portable con el que analizar dicho grado de similitud comprende un rango de tonalidades. 13. Método de análisis según cualquiera de las reivindicaciones 11 o 12, que comprende una etapa adicional de calcular el porcentaje de embutición correcto en base al grado de similitud entre la tonalidad de cada pixel y el color patrón realizado durante el barrido pixel a pixel de la imagen captada de la pieza (1) embutida. 14. Dispositivo portable de análisis de procesos de embutición para piezas de chapa, que comprende: - una unidad de memoria configurada para almacenar representaciones virtuales de piezas embutidas, - un dispositivo de entrada de datos, configurado para permitir la selección de una de las representaciones virtuales almacenadas en la unidad de memoria, - un dispositivo de captación de imágenes configurado para captar imágenes, - un dispositivo de representación gráfica configurado para representar a tiempo real las imágenes captadas, - una unidad de control, operativamente conectada a la unidad de memoria, al dispositivo de entrada de datos, al dispositivo de captación de imágenes y al dispositivo de representación gráfica, donde la unidad de control está configurada para: o controlar el dispositivo de representación gráfica para representar por medio de realidad aumentada la representación virtual (2) seleccionada de forma superpuesta a una imagen captada de una pieza (1) embutida, o determinar una coincidencia en la superposición entre la representación virtual (2) seleccionada y la imagen captada de la pieza (1) embutida, ante los desplazamientos manuales del dispositivo portable, y o analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la imagen captada de la pieza (1) embutida.

Los productos y servicios protegidos por este registro son:

G01N 21/88 - B21D 22/20

Descripciones:

+ ES-2961010_A1 Método y dispositivo portable de análisis de procesos de embutición Sector de la técnica La presente invención concierne al sector de los procesos de embutición para piezas de chapa, en concreto al de analizar la calidad de los procesos de embutición. Estado de la técnica anterior Como es conocido, el proceso de obtención de una pieza metálica, partiendo de una lámina de chapa de un determinado espesor, puede tener diferentes etapas: embutir, conformar, engrapar, cortar, punzonar, doblar, etc. La estampación o embutición es el proceso principal de transformación de chapa utilizado más frecuentemente en la fabricación de piezas para el automóvil. Es el proceso de mayor importancia para la obtención de la forma general de la pieza. La embutición podría ser definida como la acción de transformación de una chapa plana en un cuerpo hueco. Las herramientas básicas que intervienen en una operación de embutir son el punzón, la matriz y el pisador. En primer lugar el formato se posiciona sobre la matriz. A continuación, el pisador cierra moviéndose contra la matriz hasta que el formato está en contacto total por ambos lados. Cuando el formato está completamente pisado, el pisador aplica una fuerza sobre la chapa que permite controlar la entrada del material durante el proceso de embutición. El punzón entonces, empuja la chapa contra la matriz, deformándola plásticamente y obteniendo la forma de la cavidad. Por lo tanto, aunque se hable de embutición de aquí en adelante, hay que entenderlo en términos genéricos de generar una determinada geometría a una lámina de chapa, donde puede existir otras etapas posteriores como un doblado o engrapado después de la embutición o estampación en sí. En la actualidad, la evaluación de los procesos de embutición se realiza por medio de observación de la pieza por parte de expertos en embutición, quienes otorgan un valor de adecuación de la pieza obtenida por embutición. Para realizar estas pruebas, la chapa se tiñe con pintura de un color. Durante el proceso de embutición, las matrices impactan y doblan la chapa, eliminando la pintura. El experto analiza si la pintura ha sido correctamente eliminada de la pieza; si hay blanco, significa que la matriz ha retirado por abrasión la pintura de dicha zona, consiguiendo una buena embutición. Por el contrario, i la pieza mantiene el color azul, la matriz no ha presionado correctamente dicha zona, por lo que la embutición no ha sido correcta. Sin embargo, es un procedimiento subjetivo. El documento CN112098428A divulga un sistema de reconocimiento de defectos basado en visión artificial para la fabricación de materiales en láminas, con el cual se identifican y clasifican los defectos. El sistema comprende una cámara con la que captura una imagen del producto y un software realiza un filtrado en la imagen para obtener una imagen de fondo y después recorrer cada píxel de la imagen para calcular la diferencia de escala de grises respecto a una referencia y clasificarlos mediante un algoritmo de visión artificial. Sin embargo, este tipo de sistemas son costosos de implementar y poco flexibles a la hora de analizar diferentes tipos de piezas, debido a la programación o entrenamiento previo que el sistema necesita para reconocer las piezas y su posición, por lo que estos sistemas no se utilizan para los análisis de los procesos de embutición previos a la fabricación en masa. Por tanto, existe la necesidad de un método de análisis de la calidad de procesos de embutición que sea realizado de forma automática y según unos criterios objetivos, a la vez que aporte flexibilidad para aplicarlo a diferentes tipos de piezas sin costes de programación o entrenamiento añadidos. Descripción de la invención La presente invención concierne, según un primer aspecto, a un método de análisis de procesos de embutición para piezas de chapa, siendo los procesos de embutición del tipo que utilizan una matriz de deformación de piezas de chapa. El método de análisis comprende las etapas de: a) teñir una pieza de chapa a embutir con pintura de un color patrón, preferiblemente azul, pudiendo realizarse dicha etapa por medios automáticos de pintura o por medios manuales, b) embutir la pieza teñida y obtener una pieza embutida mediante un proceso de embutición a analizar, eliminando la matriz al menos parte de la pintura en aquellas zonas en las que contacta con la pieza de chapa, correspondiendo dicho contacto a una correcta embutición cuando la eliminación de la pintura de la superficie de la pieza embutida es total, mientras que las zonas en las que permanece pintura en la pieza embutida corresponden a una embutición defectuosa, c) seleccionar, por medio de un dispositivo de entrada de datos del dispositivo portable, una representación virtual de una pieza patrón relativa a la pieza mbutida, almacenada en una unidad de memoria del dispositivo portable. Dicha selección puede realizarse, por ejemplo, seleccionando de forma manual una de entre una pluralidad de representaciones virtuales de la pieza embutida almacenadas a través de una interfaz del dispositivo portable. A diferencia de los divulgados en el estado de la técnica, el presente método de análisis se caracteriza por que comprende las etapas de: d) captar, por medio de un dispositivo de captación de imágenes del dispositivo portable, la pieza embutida y mostrarla a tiempo real por medio de un dispositivo de representación gráfica (por ejemplo, una pantalla) del dispositivo portable, e) representar en el dispositivo de representación gráfica la representación virtual seleccionada de forma superpuesta a la pieza embutida captada, por medio de realidad aumentada, por ejemplo, representándose la representación virtual de forma centrada en el dispositivo de representación gráfica, f) desplazar manualmente el dispositivo portable hasta que la representación virtual superpuesta coincida con la pieza embutida mostrada a tiempo real, g) analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la pieza embutida. El presente método de análisis combina la realidad aumentada de un dispositivo portable con algoritmos de inteligencia artificial, es decir, utiliza una forma eficaz y flexible para captar diferentes piezas embutidas y hacerlas coincidir con su representación virtual, lo cual permite ampliar fácilmente el método de análisis a nuevos procesos de embutición, a la vez que utiliza algoritmos de inteligencia artificial para reconocer si la tonalidad del color a identificar coincide con la tonalidad de la pintura que se acepta como correcta. Ambas tecnologías cooperan con el fin de reducir el coste computacional y simplificar el proceso de analizar la calidad de procesos de embutición, al no necesitar una programación de reconocimiento y discretización de las piezas embutidas. De esta manera se consigue acotar y cuantificar de manera precisa la cantidad y propiedades visuales de la pintura restante en las piezas embutidas y mantener un histórico de datos de embutición que permite realizar análisis y posibles predicciones futuras de los procesos. En una posible realización, el método comprende, a la vez que se representa en el dispositivo de representación gráfica la representación virtual, alterar la transparencia de dicha representación virtual y/o proporcionar medios de ajuste para ajustar la transparencia de dicha representación virtual, de forma que el operario puede cotejar visualmente la coincidencia en 3D de la superposición de la pieza embutida y la epresentación virtual. Así, se permite la representación simultánea tanto de la representación virtual de la pieza embutida como de la pieza embutida a analizar, a través de una alteración de los parámetros de representación gráfica de la representación virtual de la pieza embutida. Los medios de ajuste pueden ser, por ejemplo, una barra virtual situada en un lateral de la pantalla, la cual es desplazable verticalmente y la transparencia cambia en función de la posición de la barra. Otro ejemplo sería mostrar en pantalla un botón "+" y un botón "-"para aumentar o disminuir la transparencia. En una posible realización, el método comprende, después de la etapa f) , una etapa 0) de cotejar la coincidencia de la superposición entre la representación virtual y la pieza embutida mostrada en el dispositivo de representación gráfica, tanto del perfil exterior como de los volúmenes o superficies, puesto que la cámara podría estar inclinada respecto a la ortogonal de la pieza embutida y sus superficies no ser coincidentes con las de la representación virtual. Esta etapa la lleva a cabo el software mediante algoritmos de inteligencia artificial. De forma preferente, el software emite un aviso cuando se ha realizado el casamiento entre volúmenes o superficies. Según una realización preferente, con el fin de minimizar los recursos de procesamiento, la representación virtual de la pieza embutida es únicamente en dos dimensiones, requiriéndose que se produzca un casamiento entre dicha superficie de la representación virtual y la pieza embutida captada. Una vez realizado dicho casamiento, el software recupera la geometría tridimensional de la pieza embutida seleccionada de la unidad de memoria del dispositivo portable, con el fin de poder realizar el análisis del grado de pintura restante en las diferentes perspectivas o enfoques de la pieza embutida. Se simplifica de este modo la etapa de casamiento, vinculando dicha etapa ejecutada por las herramientas de realidad aumentada a un casamiento entre geometrías en dos dimensiones. Alternativamente, dicho casamiento o comparación de la coincidencia se realiza con información tridimensional, tanto de la representación virtual de la pieza embutida como de la pieza embutida a estudio representada, de manera que se facilita la existencia de dicha coincidencia. En una posible realización, el método comprende, preferiblemente después de la etapa f) y comprenda o no la etapa 6) , una etapa f2) de registrar al menos una imagen de la pieza embutida captada por el dispositivo de representación gráfica y almacenarla en la unidad de memoria del dispositivo portable, siendo esta la al menos una imagen utilizada para llevar a cabo la etapa g) . Nuevamente con el objetivo de reducir los recursos de procesamiento del software requeridos, el análisis mediante algoritmos de inteligencia artificial del grado de pintura restante en la pieza embutida se realiza sobre imágenes oncretas captadas por el usuario a través del dispositivo de captación de imágenes del dispositivo portable, en lugar de un procesamiento y análisis de grado de pintura restante a tiempo real de la pieza embutida captada por dicho dispositivo. Opcionalmente, la etapa g) comprende eliminar el entorno no perteneciente a la pieza embutida en la al menos una imagen de la pieza embutida, lo que permite determinar exactamente el volumen o la superficie de la pieza embutida. Por ejemplo, la etapa g) comprende la aplicación de un filtro blanco/negro a la al menos una imagen de la pieza embutida. En una realización preferente, el método comprende, previamente a la etapa g) , una etapa f3) de delimitar en la pieza embutida unas zonas de estudio correspondientes a las zonas a analizar en la etapa g) . En concreto, las zonas de principal interés para estudiar la calidad de embutición corresponden con las zonas perimetrales de la pieza embutida. De este modo, la etapa g) de análisis de centra en dichas zonas de mayor interés. En una implementación preferente, la etapa f3) de delimitar las zonas de estudio comprende transferir, por medio de realidad aumentada, unos límites que definen dichas zonas de estudio a la al menos una imagen de la pieza embutida captada, estando dichos límites previamente definidos en la representación virtual. De este modo, las librerías de realidad aumentada reconocen las zonas concretas de estudio (definidas por los límites previamente definidos) de la al menos una imagen captada de la pieza embutida, por lo que los algoritmos de inteligencia artificial aplicados para analizar el grado de pintura restante en la pieza embutida son aplicados únicamente sobre dichas zonas de estudio delimitadas por la realidad aumentada. Opcionalmente, en la etapa f3) , dichos límites pueden afinarse o modificarse manualmente marcando táctilmente dichas zonas en el dispositivo de representación gráfica o pantalla (por ejemplo, las zonas señaladas manualmente pueden ser zonas a extraer de las zonas de estudio) . Gracias a ello, la etapa g) de analizar mediante algoritmos de inteligencia artificial el grado de pintura restante en la pieza embutida es ejecutada únicamente en las zonas de estudio delimitada de la pieza embutida. Con ello, en una misma etapa, se aplica la realidad aumentada y los algoritmos de visión artificial para reducir el coste computacional del análisis de la pieza embutida. Por ejemplo, la etapa de transferir dichos límites comprende superponer unas líneas de un color predefinido, diferente al color patrón, en la al menos una imagen captada de la pieza embutida, por medio de realidad aumentada. En este caso y de forma preferible, la etapa f3) de delimitar las zonas de estudio comprende adicionalmente aplicar un filtro de etección del color predefinido y realizar una detección de dicho color predefinido pixel a pixel para determinar las líneas de color predefinido superpuestas por medio de realidad aumentada en la imagen captada de la pieza embutida. De este modo se delimitan las zonas de estudio a analizar. En una posible realización, la etapa g) comprende realizar un barrido pixel a pixel para analizar el grado de similitud entre la tonalidad de cada pixel y el color patrón almacenado en el dispositivo de memoria del dispositivo portable. De forma preferente, el color patrón almacenado en el dispositivo de memoria del dispositivo portable con el que analizar dicho grado de similitud comprende un rango de tonalidades, preferiblemente calibrable, ya sea proporcionando medios de calibración para calibrar a mano dicho rango de similitud o calibrándolo el software de forma automática. De forma opcional, el método comprende una etapa adicional de calcular el porcentaje de embutición correcto en base al grado de similitud entre la tonalidad de cada pixel y el color patrón realizado durante el barrido pixel a pixel de la imagen captada de la pieza embutida. Dicho cálculo se puede llevar a cabo por porciones de la pieza embutida, dividiendo la imagen de la pieza embutida en una cuadrícula. De la misma forma, el dispositivo portable puede mostrar por pantalla el resultado obtenido para cada porción de la cuadrícula. Un segundo aspecto de la presente invención consiste en un dispositivo portable de análisis de procesos de embutición para piezas de chapa, el cual comprende: - una unidad de memoria configurada para almacenar representaciones virtuales de piezas embutidas, - un dispositivo de entrada de datos, configurado para permitir la selección de una de las representaciones virtuales almacenadas en la unidad de memoria, - un dispositivo de captación de imágenes configurado para captar imágenes, - un dispositivo de representación gráfica configurado para representar a tiempo real las imágenes captadas, - una unidad de control, operativamente conectada a la unidad de memoria, al dispositivo de entrada de datos, al dispositivo de captación de imágenes y al dispositivo de representación gráfica, donde la unidad de control está configurada para: o controlar el dispositivo de representación gráfica para representar por medio de realidad aumentada la representación virtual seleccionada de forma superpuesta a una imagen captada de una pieza embutida, o determinar una coincidencia en la superposición entre la representación virtual seleccionada y la imagen captada de la pieza embutida, ante los desplazamientos manuales del dispositivo portable, y o analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en la imagen captada de la pieza embutida. El objetivo de la presente invención es implementar en un dispositivo portable, por lo tanto, desplazable por parte del usuario para poder analizar en cualquier situación, ubicación y estado la calidad de embutición de una pieza embutida, donde el dispositivo portable tenga un sistema de captación de imágenes, un software que combine Realidad Aumentada con Visión Artificial, buscando que el análisis de calidad de la embutición sea realizado de forma automática y según unos criterios objetivos. Breve descripción de los dibujos Las anteriores y otras ventajas y características se comprenderán más plenamente a partir de la siguiente descripción detallada de unos ejemplos de realización con referencia a los dibujos adjuntos, que deben tomarse a título ilustrativo y no limitativo, en los que: - La fig. 1 ilustra un diagrama de bloques que muestra el orden de las etapas de un ejemplo de realización del presente método de análisis de procesos de embutición. - La fig. 2 ilustra una imagen de ejemplo reproducida por un dispositivo de representación gráfica del dispositivo portable usado durante la etapa e) del presente procedimiento. - La fig. 3 ilustra otra imagen de ejemplo consistente en la representación virtual superpuesta de forma coincidente con la pieza embutida al llevar a cabo la etapa e) del presente procedimiento. - La fig. 4 ilustra un ejemplo de aplicación de la etapa f3) , en la que se muestran los límites predefinidos en la representación virtual a transferir a la imagen captada de la pieza embutida por medio de realidad aumentada. - La fig. 5 ilustra una imagen que ejemplifica la aplicación en la etapa f3) de un filtro de detección del color predefinido para determinar las zonas de estudio. - La fig. 6 ilustra una imagen de ejemplo que muestra el cálculo del porcentaje de embutición correcto en base al grado de similitud entre la tonalidad de cada pixel de la pieza embutida y el color patrón. Descripción detallada de unos ejemplos de realización En la figura 1 se encuentra ilustrado un diagrama de bloques que muestra el orden de las etapas de un ejemplo de realización del presente método de análisis de procesos de embutición para piezas de chapa. Esta realización comprende las etapas de: a) teñir una pieza (1) de chapa a embutir con pintura de un color patrón, siendo dicha etapa ejecutada de forma manual por parte de un operario o de forma automática por parte de un equipo de pintura, b) embutir la pieza (1) teñida y obtener una pieza (1) embutida mediante un proceso de embutición, c) seleccionar, por medio de un dispositivo de entrada de datos de un dispositivo portable, una representación virtual (2) de la pieza (1) embutida, almacenada en una unidad de memoria del dispositivo portable, d) captar, por medio de un dispositivo de captación de imágenes del dispositivo portable, la pieza (1) embutida y mostrarla a tiempo real por medio de un dispositivo de representación gráfica del dispositivo portable, e) representar en el dispositivo de representación gráfica la representación virtual (2) seleccionada de forma superpuesta a la pieza (1) embutida captada, por medio de realidad aumentada, f) desplazar manualmente el dispositivo portable hasta que la representación virtual (2) seleccionada coincida con la pieza (1) embutida mostrada a tiempo real, 0) cotejar la coincidencia de la superposición entre la representación virtual (2) y la pieza (1) embutida mostrada en el dispositivo de representación gráfica, f2) registrar y almacenar en la unidad de memoria del dispositivo portable al menos una imagen de la pieza (1) embutida, una vez se ha determinado una coincidencia en la superposición entre la representación virtual (2) y la pieza (1) embutida, f3) delimitar en la al menos imagen registrada de la pieza (1) embutida unas zonas de estudio (10) correspondientes a las zonas a analizar en la etapa g) , en base a unos límites (20) que definen dichas zonas de estudio (10) , los cuales se encuentran previamente definidos en la representación virtual (2) , g) analizar, mediante algoritmos de inteligencia artificial, el grado de pintura restante en las zonas de estudio (10) de la pieza (1) embutida. La fig. 2 ilustra una imagen de ejemplo reproducida por un dispositivo de representación gráfica del dispositivo portable usado durante la etapa e) del presente procedimiento. Esta imagen de la fig. 2 muestra la representación virtual (2) relativa a una pieza (1) embutida de ejemplo, así como una porción de dicha pieza (1) embutida captada a tiempo eal con el dispositivo de captación de imágenes del dispositivo portable. Se observa como la pieza (1) embutida no está comprendida totalmente en el campo de visión del dispositivo de captación de imágenes del dispositivo portable, por lo que aparece cortada. Por su lado, se observa como la representación virtual (2) previamente seleccionada por el usuario relativa a la pieza (1) embutida aparece representada en el centro del dispositivo de representación gráfica. Dicha representación está además alterada en cuanto a su transparencia, permitiendo al usuario poder observar simultáneamente tanto dicha representación virtual (2) como la imagen a tiempo real captada de la pieza (1) embutida. En la fig. 3 se ha ilustrado otra imagen de ejemplo reproducida por el dispositivo de representación gráfica en el momento en que el usuario, moviendo el dispositivo portable, ha hecho coincidir de forma superpuesta la representación virtual (2) con la pieza (1) embutida durante la etapa e) del presente procedimiento. Por medio de la representación en realidad aumentada se permite que exista una coincidencia entre ambas representaciones de la pieza. La fig. 4 ilustra un ejemplo de aplicación de la etapa f3) , en la que se muestran los límites (20) predefinidos de la representación virtual (2) a transferir a la imagen de la pieza (1) embutida por medio de realidad aumentada, los cuales definen las zonas de estudio (10) a analizar de la pieza (1) embutida en la etapa g) , a la vez que se muestran las zonas señaladas manualmente (21) que deben ser extraídas de las zonas de estudio (10) . En consecuencia, una vez determinada la coincidencia entre la pieza (1) embutida y su representación virtual (2) , la unidad de control realiza una captación de diferentes imágenes de la pieza (1) embutida por medio del dispositivo de captación de imágenes. Dichas imágenes son almacenadas en la unidad de memoria. La unidad de control recupera la información tridimensional de la pieza a estudio almacenada en la unidad de memoria del dispositivo portable con el fin de establecer una coincidencia entre las diferentes perspectivas de las diferentes imágenes de la pieza (1) embutida captadas. Por medio de las correspondientes librerías de realidad aumentada, se establecen unos límites (20) que definen unas zonas de estudio (10) correspondientes a las zonas a analizar en la etapa g) . Dicha delimitación de las zonas de estudio (10) permite que el análisis por visión computacional se ejecute únicamente sobre dichas zonas de estudio En la fig. 5 se ha ilustrado una imagen que ejemplifica la aplicación de un filtro de detección de un color predefinido para determinar dichas zonas de estudio (10) al llevar a cabo la etapa f3) . Una vez determinadas dichas zonas de estudio (10) , se aplican unos algoritmos de visión artificial con el fin de determinar las áreas de las zonas de estudio (10) de color azul, así como un rango de similitud a ese color azul patrón, por medio de filtros de color azul. La fig. 6 ilustra imagen de ejemplo que muestra el cálculo del porcentaje de embutición correcto de la pieza (1) embutida para las diferentes porciones (31) de una cuadrícula (3) , en base al grado de similitud entre la tonalidad de cada pixel de la pieza (1) embutida y el color patrón, obtenido durante el barrido pixel a pixel de la imagen captada de la pieza (1) embutida llevado a cabo en la etapa g) . Así, la unidad de control crea un reporte indicando el porcentaje correcto de embutición total, así como porcentajes parciales dividiendo la superficie de la pieza (1) embutida en porciones según el tamaño de la pieza a analizar, por ejemplo, para el ejemplo en cuestión, una cuadrícula 9x5.

Publicaciones:

ES2961010 (07/03/2024) - A1 Solicitud de patente con informe sobre el estado de la técnica

Eventos:

En fecha 05/08/2022 se realizó Registro Instancia de Solicitud

En fecha 08/08/2022 se realizó Admisión a Trámite

En fecha 08/08/2022 se realizó 1001P_Comunicación Admisión a Trámite

En fecha 16/09/2022 se realizó Superado examen de oficio

En fecha 16/12/2022 se realizó Realizado IET

En fecha 23/12/2022 se realizó 1109P_Comunicación Traslado del IET

En fecha 07/03/2024 se realizó Publicación Solicitud

En fecha 07/03/2024 se realizó Publicación Folleto Solicitud con IET (A1)

En fecha 19/04/2024 se realizó PETEX_Petición de examen sustantivo

Pagos:

05/08/2022 - Pago Tasas IET

Fuente de la información

Parte de la información aquí publicada es pública puesto que ha sido obtenida de la Oficina de Propiedad Industrial de los diferentes países el 29/04/2024 y por lo tanto puede ser que la información no esté actualizada.Parte de la información aquí mostrada ha sido calculada por nuestro sistema informático y puede no ser veraz.

Privacidad

Si considera que al información aquí publicada afecta a su privacidad y desea que eliminemos la información aquí publicada envíe un email a info@patentes-y-marcas.com o rellene el formulario que encontrará aquí.Información sobre el registro de patente nacional por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728

El registro de patente nacional por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728 fue solicitada el 05/08/2022. Se trata de un registro en España por lo que este registro no ofrece protección en el resto de países. El registro MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728 fue solicitada por SEAT, S.A. mediante los servicios del agente PONTI & PARTNERS, S.L.P.. El registro [modality] por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728 está clasificado como G01N 21/88,B21D 22/20 según la clasificación internacional de patentes.

Otras invenciones solicitadas por SEAT, S.A.

Es posible conocer todas las invenciones solicitadas por SEAT, S.A. entre las que se encuentra el registro de patente nacional por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Si se desean conocer más invenciones solicitadas por SEAT, S.A. clicar aquí.Otras invenciones solicitadas en la clasificación internacional de patentes G01N 21/88,B21D 22/20.

Es posible conocer invenciones similares al campo de la técnica se refiere. El registro de patente nacional por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728 está clasificado con la clasificación G01N 21/88,B21D 22/20 por lo que si se desea conocer más registros con la clasificación G01N 21/88,B21D 22/20 clicar aquí.Otras invenciones solicitadas a través del representante PONTI & PARTNERS, S.L.P.

Es posible conocer todas las invenciones solicitadas a través del agente PONTI & PARTNERS, S.L.P. entre las que se encuentra el registro patente nacional por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Si se desean conocer más invenciones solicitadas a través del agente PONTI & PARTNERS, S.L.P. clicar aquí.Patentes en España

Es posible conocer todas las invenciones publicadas en España entre las que se encuentra el registro patente nacional por MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN. Nuestro portal www.patentes-y-marcas.com ofrece acceso a las publicaciones de patentes en España. Conocer las patentes registradas en un país es importante para saber las posibilidades de fabricar, vender o explotar una invención en España.Patentes registradas en la clase G

Es posible conocer todas las patentes registradas en la clase G (FISICA) entre las que se encuentra la patente MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Conocer las patentes registradas en una clase es importante para saber las posibilidades de registrar una patente en esa misma clase.Patentes registradas en la clase G01

Es posible conocer todas las patentes registradas en la clase G01 (METROLOGIA; ENSAYOS) entre las que se encuentra la patente MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Conocer las patentes registradas en una clase es importante para saber las posibilidades de registrar una patente en esa misma clase.Patentes registradas en la clase G01N

Es posible conocer todas las patentes registradas en la clase G01N (INVESTIGACION O ANALISIS DE MATERIALES POR DETERMINACION DE SUS PROPIEDADES QUIMICAS O FISICAS) entre las que se encuentra la patente MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Conocer las patentes registradas en una clase es importante para saber las posibilidades de registrar una patente en esa misma clase.Patentes registradas en la clase B

Es posible conocer todas las patentes registradas en la clase B (TECNICAS INDUSTRIALES DIVERSAS; TRANSPORTE ) entre las que se encuentra la patente MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Conocer las patentes registradas en una clase es importante para saber las posibilidades de registrar una patente en esa misma clase.Patentes registradas en la clase B21

Es posible conocer todas las patentes registradas en la clase B21 (TRABAJO MECANICO DE LOS METALES SIN ARRANQUE SUSTANCIAL DE MATERIAL; CORTE DEL METAL POR PUNZONAD) entre las que se encuentra la patente MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Conocer las patentes registradas en una clase es importante para saber las posibilidades de registrar una patente en esa misma clase.Patentes registradas en la clase B21D

Es posible conocer todas las patentes registradas en la clase B21D (TRABAJO MECANICO O TRATAMIENTO DE CHAPAS, TUBOS, BARRAS O PERFILES METALICOS SIN ARRANQUE SUSTANCIAL) entre las que se encuentra la patente MÉTODO Y DISPOSITIVO PORTABLE DE ANÁLISIS DE PROCESOS DE EMBUTICIÓN con el número P202230728. Conocer las patentes registradas en una clase es importante para saber las posibilidades de registrar una patente en esa misma clase.

¿Tienes alguna duda?

Escribe tu consulta y te responderemos rápida y gratuitamente.

Otras patentes similares

P202230726

P202230726