- Home /

- Publicaciones de patentes /

- LECTORES DE CÓDIGOS DE BARRAS CON UNA O VARIAS CÁMARAS 3D

Patente nacional por "LECTORES DE CÓDIGOS DE BARRAS CON UNA O VARIAS CÁMARAS 3D"

Este registro ha sido solicitado por

ZEBRA TECHNOLOGIES CORPORATION

a través del representanteDURAN-CORRETJER, S.L.P

Contacto

- Estado: A punto de caducar

- País:

- España

- Fecha solicitud:

- 27/05/2021

- Número solicitud:

-

P202430139

- Número publicación:

-

ES2967105

- Fecha de concesión:

-

- Inventores:

-

Persona física

- Datos del titular:

-

ZEBRA TECHNOLOGIES CORPORATION

- Datos del representante:

-

DURAN-CORRETJER, S.L.P

- Clasificación Internacional de Patentes:

- G06K 19/00

- Clasificación Internacional de Patentes de la publicación:

- G06K 19/00

- Fecha de vencimiento:

Quiero registrar una patente

Reivindicaciones:

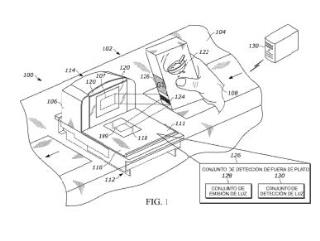

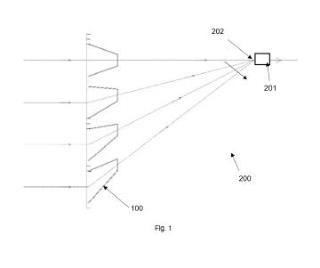

+ ES-2967105_A21. Procedimiento de procesamiento de datos utilizando un lector de códigos de barras, comprendiendo el procedimiento: capturar, utilizando un aparato de formación de imágenes bidimensionales (2D) dentro del lector de códigos de barras y que tiene un primer campo de visión (FOV) , una imagen 2D de un primer entorno que aparece dentro del primer FOV y almacenar datos de imagen 2D correspondientes a la imagen 2D; capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) asociado con el lector de códigos de barras y que tiene un segundo FOV que se superpone, por lo menos parcialmente, con el primer FOV, una imagen 3D de un segundo entorno que aparece dentro del segundo FOV y almacenar datos de imagen 3D correspondientes a la imagen 3D; identificar una o varias características de imagen 2D dentro del primer entorno a partir de los datos de imagen 2D; mejorar los datos de imagen 3D, dando como resultado datos de imagen 3D mejorados, mediante correlacionar las una o varias características de imagen 2D con por lo menos una o varias características de imagen 3D en los datos de imagen 3D; y procesar los datos de imagen 3D mejorados para por lo menos uno de (a) entrenar un modelo de reconocimiento de objetos con los datos de imagen 3D mejorados, (b) reconocer un objeto dentro de los datos de imagen 3D mejorados, (c) identificar una acción llevada a cabo por un usuario del lector de códigos de barras, y (d) cambiar por lo menos un parámetro asociado con el aparato de formación de imágenes 3D. 2. Procedimiento, según la reivindicación 1, en el que los datos de imagen 2D comprenden uno de datos de imagen monocromática, datos de imagen en escala de grises y datos de imagen polícroma, y en el que las una o varias características de imagen 2D incluyen por lo menos una de un código de barras y una o varias características geométricas de un objeto presentado dentro del primer FOV. 3. Procedimiento, según la reivindicación 2, en el que las una o varias características de imagen 2D incluyen el código de barras, y en el que mejorar los datos de imagen 3D incluye asignar una ubicación del código de barras de los datos de imagen 2D a los datos de imagen 3D. 4. Procedimiento, según la reivindicación 2, en el que los datos de imagen 2D comprenden datos de imagen polícroma, en el que las una o varias características de imagen 2D incluyen las una o varias características geométricas del objeto presentado dentro del primer FOV, y en el que mejorar los datos de imagen 3D incluye asignar por lo menos una parte de los datos de imagen polícroma a los datos de imagen 3D basándose, por lo menos en parte, en las una o varias características geométricas del objeto presentado dentro del primer FOV. 5. Procedimiento, según la reivindicación 2, en el que mejorar los datos de imagen 3D incluye, además, filtrar las por lo menos una o varias características de imagen 3D de modo que procesar los datos de imagen 3D mejorados excluye procesar datos de imagen asociados con las por lo menos una o varias características de imagen 3D. 6. Procedimiento, según la reivindicación 2, en el que mejorar los datos de imagen 3D incluye, además, filtrar las por lo menos una o varias características de imagen 3D de modo que procesar los datos de imagen 3D mejorados se limita a procesar los datos de imagen asociados con las por lo menos una o varias características de imagen 3D. 7. Procedimiento, según la reivindicación 2, en el que mejorar los datos de imagen 3D incluye, además, filtrar los datos de imagen 3D basándose en un intervalo de distancia predeterminado fuera del aparato de formación de imágenes 3D. 8. Procedimiento, según la reivindicación 7, en el que el lector de códigos de barras es un lector de códigos de barras estacionario configurado para ser posicionado dentro de una estación de trabajo y manejado por el operario, y en el que el intervalo de distancia predeterminado fuera del aparato de formación de imágenes 3D se extiende desde el aparato de formación de imágenes 3D hasta un borde de la estación de trabajo próximo al operario. 9. Procedimiento, según la reivindicación 7, en el que el lector de códigos de barras es un lector de códigos de barras bióptico que tiene una zona de escaneado de producto, y en el que el intervalo de distancia predeterminado fuera del aparato de formación de imágenes 3D se extiende desde el aparato de formación de imágenes 3D hasta el límite distal de la zona de escaneado de producto. 10. Procedimiento, según la reivindicación 1, en el que las una o varias características de imagen 2D incluyen por lo menos una de (i) por lo menos una parte de una mano del operario, y (ii) un objeto agarrado por la mano del operario. 11. Procedimiento, según la reivindicación 1, en el que procesar los datos de imagen 3D mejorados incluye identificar la acción llevada a cabo por el operario, y en respuesta a identificar la acción llevada a cabo por el operario como una de presentar un objeto dentro de una zona de escaneado de producto y presentar el objeto próximo a la zona de escaneado de producto y, en respuesta, además, a que no se detecta ningún código de barras dentro de los datos de imagen 2D, generar una alerta adecuada para señalizar un potencial evento de robo. 12. Procedimiento, según la reivindicación 1, en el que identificar las una o varias características de imagen 2D comprende: identificar características del entorno en la imagen 2D, en el que las características del entorno son características en la imagen fuera de un objeto presentado dentro del primer FOV; convertir las características del entorno en características de máscara configuradas para cubrir las características del entorno identificadas en la imagen 2D; e identificar las características de máscara como las una o varias características de imagen 2D. 13. Procedimiento, según la reivindicación 1, en el que identificar una o varias características de imagen 2D comprende: identificar un código de barras para el objeto en los datos de imagen 2D; descodificar el código de barras para generar datos de carga útil de código de barras y determinar la identificación del objeto a partir de los datos de carga útil de código de barras; y determinar, a partir de la identificación del objeto, las una o varias características de imagen 2D. 14. Procedimiento, según la reivindicación 1, en el que procesar los datos de imagen 3D mejorados para entrenar el modelo de reconocimiento de objetos con los datos de magen 3D mejorados comprende: identificar un código de barras en los datos de imagen 2D, determinar un período de tiempo de evento de detección de código de barras y entrenar el modelo de reconocimiento de objetos con los datos de imagen 3D mejorados correspondientes al período de tiempo de evento de detección de código de barras; o identificar un código de barras en los datos de imagen 2D, identificar el objeto dentro de los datos de imagen 3D mejorados correspondiente al código de barras en los datos de imagen 2D, y, después de identificar otro objeto en la imagen 3D no correspondiente al código de barras, eliminar los otros objetos de los datos de imagen 3D mejorados antes de entrenar el modelo de reconocimiento de objetos con los datos de imagen 3D mejorados. 15. Procedimiento, según la reivindicación 1, en el que el por lo menos un parámetro asociado con el aparato de formación de imágenes 3D comprende una cantidad de iluminación proyectada del aparato de formación de imágenes 3D, una dirección de iluminación proyectada del aparato de formación de imágenes 3D, o una fuente de iluminación para el aparato de formación de imágenes 3D. 16. Procedimiento para identificar un escaneado apropiado de un objeto o un escaneado inapropiado del objeto utilizando un lector de códigos de barras, comprendiendo el procedimiento: capturar, utilizando un aparato de formación de imágenes bidimensionales (2D) dentro del lector de códigos de barras y que tiene un primer campo de visión (FOV) , una imagen 2D de un primer entorno que aparece dentro del primer FOV y almacenar datos de imagen 2D correspondientes a la imagen 2D; capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) asociado con el lector de códigos de barras y que tiene un segundo FOV que se superpone, por lo menos parcialmente, con el primer FOV, una imagen 3D de un segundo entorno que aparece dentro del segundo FOV y almacenar datos de imagen 3D correspondientes a la imagen 3D; determinar una primera identificación de objeto del objeto utilizando los datos de imagen 2D; determinar una segunda identificación de objeto del objeto utilizando los datos de imagen 3D; y comparar la primera identificación del objeto con la segunda identificación del objeto, y determinar (a) el escaneado apropiado del objeto cuando la primera identificación del objeto coincide con la segunda identificación del objeto y (b) el escaneado inapropiado del objeto cuando la primera identificación del objeto no coincide con la segunda identificación del objeto. 17. Procedimiento, según la reivindicación 16, en el que determinar la primera identificación de objeto del objeto utilizando los datos de imagen 2D comprende: identificar un código de barras para el objeto en los datos de imagen 2D; y descodificar el código de barras para generar datos de carga útil de código de barras y determinar la primera identificación del objeto a partir de los datos de carga útil de código de barras. 18. Procedimiento, según la reivindicación 16, en el que determinar la primera identificación de objeto del objeto utilizando los datos de imagen 2D comprende: proporcionar los datos de imagen 2D a un modelo de reconocimiento de objetos entrenado; y producir, utilizando el modelo de reconocimiento de objetos entrenado, la primera identificación de objeto del objeto. 19. Procedimiento, según la reivindicación 16, en el que determinar la segunda identificación de objeto del objeto utilizando los datos de imagen 3D comprende: proporcionar los datos de imagen 3D a un modelo de reconocimiento de objetos entrenado; y producir, utilizando el modelo de reconocimiento de objetos entrenado, la segunda identificación de objeto del objeto. 20. Procedimiento, según la reivindicación 16, en el que antes de determinar la primera identificación de objeto del objeto utilizando los datos de imagen 2D, el procedimiento comprende, además: comparar los datos de imagen 3D con los datos de imagen 2D; y eliminar características del entorno fuera del objeto de los datos de imagen 2D asándose en los datos de imagen 3D. 21. Procedimiento, según la reivindicación 16, en el que antes de determinar la segunda identificación de objeto del objeto utilizando los datos de imagen 3D, el procedimiento comprende: comparar los datos de imagen 3D con los datos de imagen 2D; y eliminar características del entorno fuera del objeto de los datos de imagen 3D basándose en los datos de imagen 2D. 22. Procedimiento, según la reivindicación 16, en el que determinar la segunda identificación de objeto del objeto utilizando los datos de imagen 3D comprende: determinar una o varias características de color del objeto a partir de los datos de imagen 3D; y determinar la segunda identificación del objeto a partir de las una o varias características de color. 23. Procedimiento, según la reivindicación 22, en el que las una o varias características de color comprenden un color del objeto. 24 Procedimiento, según la reivindicación 22, en el que las una o varias características de color comprenden un gradiente de color del objeto. 25. Procedimiento, según la reivindicación 16, en el que determinar la segunda identificación de objeto del objeto utilizando los datos de imagen 3D comprende: determinar una o varias características geométricas del objeto a partir de los datos de imagen 3D; y determinar la segunda identificación del objeto a partir de las una o varias características geométricas. 26. Procedimiento, según la reivindicación 25, en el que determinar la primera identificación de objeto del objeto utilizando los datos de imagen 2D comprende: identificar un código de barras para el objeto en los datos de imagen 2D; y escodificar el código de barras para generar datos de carga útil de código de barras y determinar la primera identificación del objeto a partir de los datos de carga útil de código de barras. 27. Procedimiento, según la reivindicación 26, en el que los datos de imagen 3D incluyen una nube de puntos que comprende una pluralidad de puntos de datos, teniendo cada uno de los puntos de datos un valor de distancia asociado con una distancia desde el aparato de formación de imágenes 3D, y en el que determinar las una o varias características geométricas del objeto a partir de los datos de imagen 3D se basa en un primer subconjunto de los datos de imagen 3D y no se basa en un segundo subconjunto de los datos de imagen 3D, estando asociado el primer subconjunto de los datos de imagen 3D con un primer subconjunto de los puntos de datos que tienen el valor de distancia respectivo asociado con la distancia desde al aparato de formación de imágenes 3D dentro de un intervalo predeterminado, estando asociado el segundo subconjunto de los datos de imagen 3D con un segundo subconjunto de los puntos de datos que tienen el valor de distancia respectivo asociado con la distancia desde el aparato de formación de imágenes 3D fuera del intervalo predeterminado. 28. Procedimiento, según la reivindicación 16, en el que, en respuesta a determinar (a) el escaneado apropiado del objeto, el procedimiento comprende, además, procesar un registro de transacciones para incluir los datos asociados con el objeto, y en respuesta a determinar (b) el escaneado inapropiado del objeto, el procedimiento comprende, además, por lo menos uno de (i) generar una alerta adecuada para señalizar un potencial evento de robo, y (ii) procesar el registro de transacciones para no incluir los datos asociados con el objeto. 29. Procedimiento para identificar un escaneado inapropiado del objeto utilizando un lector de códigos de barras, comprendiendo el procedimiento: capturar, utilizando un aparato de formación de imágenes bidimensionales (2D) dentro del lector de códigos de barras y que tiene un primer campo de visión (FOV) , una imagen 2D de un primer entorno que aparece dentro del primer FOV y almacenar datos de imagen 2D correspondientes a la imagen 2D; capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) asociado con el lector de códigos de barras y que tiene un segundo FOV que se superpone, por lo enos parcialmente, con el primer FOV, una imagen 3D de un segundo entorno que aparece dentro del segundo FOV y almacenar datos de imagen 3D correspondientes a la imagen 3D; identificar un objeto escaneable utilizando los datos de imagen 3D; y después de no poder determinar una identificación de objeto del objeto utilizando los datos de imagen 2D, determinar un escaneado inapropiado del objeto y generar una señal de alarma. 30. Procedimiento de funcionamiento de un lector de códigos de barras, comprendiendo el procedimiento: capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) dentro del lector de códigos de barras y que tiene un primer FOV, una imagen 3D de un primer entorno que aparece dentro del primer FOV y almacenar datos de imagen 3D correspondientes a la imagen 3D; llevar a cabo reconocimiento facial sobre los datos de imagen 3D e identificar una presencia de datos faciales en los datos de imagen 3D; y en respuesta a identificar la presencia de los datos faciales, ajustar por lo menos un parámetro de funcionamiento de un aparato de formación de imágenes bidimensionales (2D) dentro del lector de códigos de barras. 31. Procedimiento, según la reivindicación 30, en el que el lector de códigos de barras es un lector de códigos de barras de presentación, y en el que ajustar el por lo menos un parámetro de funcionamiento del aparato de formación de imágenes 2D incluye reducir la intensidad de por lo menos uno de un conjunto de iluminación y un conjunto de apuntamiento. 32. Procedimiento, según la reivindicación 30, en el que el lector de códigos de barras es un lector de códigos de barras de presentación, y en el que ajustar el por lo menos un parámetro de funcionamiento del aparato de formación de imágenes 2D incluye impedir la activación de por lo menos alguna parte del aparato de formación de imágenes 2D hasta que una realización subsiguiente de reconocimiento facial sobre unos datos de imagen 3D subsiguientes asociados con una imagen 3D subsiguiente no pueda identificar otra presencia de datos faciales en los datos de imagen 3D subsiguientes. 33. Procedimiento, según la reivindicación 30, en el que el procedimiento incluye, además, capturar una imagen 2D de un objeto, utilizar el aparato de formación de imágenes 2D ajustado según el por lo menos un parámetro de funcionamiento, y descodificar un código de barras en la imagen 2D para identificar el objeto. 34. Procedimiento, según la reivindicación 30, en el que identificar la presencia de los datos faciales en los datos de imagen 3D comprende determinar una posición de los datos faciales en un primer FOV del aparato de formación de imágenes 3D, y en el que ajustar los parámetros de funcionamiento del aparato de formación de imágenes 2D comprende ajustar los parámetros de funcionamiento basándose en la posición de los datos faciales. 35. Procedimiento, según la reivindicación 30, en el que los parámetros de funcionamiento comprenden un segundo FOV del aparato de formación de imágenes 2D. 36. Procedimiento, según la reivindicación 30, en el que los parámetros de funcionamiento comprenden una distancia focal del aparato de formación de imágenes 2D. 37. Procedimiento, según la reivindicación 30, en el que el por lo menos un parámetro de funcionamiento del aparato de formación de imágenes 2D es un tiempo de exposición, una duración de pulso de iluminación o un nivel de ampliación de imágenes. 38. Procedimiento de funcionamiento de un lector de códigos de barras, comprendiendo el procedimiento: capturar, utilizando un aparato de formación de imágenes bidimensionales (2D) dentro del lector de códigos de barras y que tiene un primer campo de visión (FOV) , una imagen 2D de un primer entorno que aparece dentro del primer FOV y almacenar datos de imagen 2D correspondientes a la imagen 2D; llevar a cabo reconocimiento facial sobre los datos de imagen 2D e identificar una presencia de datos faciales en los datos de imagen 2D; capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) dentro del lector de códigos de barras y que tiene un primer FOV, una imagen 3D de un segundo entorno que aparece dentro del primer FOV y almacenar datos de imagen 3D correspondientes a la imagen 3D; y en respuesta a identificar una o varias características de imagen 3D asociadas con los datos faciales en los datos de imagen 2D, llevar a cabo por lo menos uno de (a) determinar una distancia de los datos faciales desde el lector de códigos de barras y activar/desactivar selectivamente el escaneado del lector de códigos de barras basándose en la distancia, (b) determinar datos antropométricos para los datos faciales y determinar si los datos faciales son de una persona o no, y (c) ajustar por lo menos un parámetro de funcionamiento del aparato de formación de imágenes 2D dentro del lector de códigos de barras. 39. Procedimiento, según la reivindicación 38, en el que el por lo menos un parámetro de funcionamiento del aparato de formación de imágenes 2D es un tiempo de exposición, una duración de pulso de iluminación, una posición de foco o un nivel de ampliación de imágenes. 40. Procedimiento, según la reivindicación 38, en el que identificar la presencia de los datos faciales en los datos de imagen 3D comprende determinar una posición de los datos faciales en un primer FOV del aparato de formación de imágenes 3D, y en el que ajustar los parámetros de funcionamiento del aparato de formación de imágenes 2D comprende ajustar los parámetros de funcionamiento basándose en la posición de los datos faciales. 41. Procedimiento de funcionamiento de una estación de escaneado de punto de venta que tiene un lector de códigos de barras, comprendiendo el procedimiento: capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) asociado con la estación de escaneado de punto de venta y que tiene un primer FOV, una imagen 3D de un primer entorno que aparece dentro del primer FOV y almacenar datos de imagen 3D correspondientes a la imagen 3D; llevar a cabo reconocimiento facial sobre los datos de imagen 3D e identificar una presencia de datos faciales en los datos de imagen 3D; llevar a cabo una identificación facial sobre los datos faciales y autenticar la identificación facial; y en respuesta a autenticar la identificación facial, por lo menos uno de (a) capturar una imagen bidimensional (2D) de un objeto utilizando un aparato de formación de imágenes 2D dentro del lector de códigos de barras y descodificar un código de barras en la imagen 2D para identificar el objeto y (b) cumplir una condición de liberación para impedir una escodificación de un código de barras capturado en la imagen de la imagen 2D o para impedir añadir un elemento escaneado subsiguientemente a un registro de transacciones de elementos escaneados. 42. Procedimiento, según la reivindicación 41, en el que autenticar la identificación facial comprende comparar la identificación facial con una base de datos de usuarios autorizados. 43. Procedimiento, según la reivindicación 41, en el que autenticar la identificación facial comprende determinar que los datos faciales están en una posición aceptable dentro del primer FOV del aparato de formación de imágenes 3D. 44. Procedimiento, según la reivindicación 41, en el que antes de llevar a cabo reconocimiento facial sobre los datos de imagen 3D y de identificar la presencia de los datos faciales en los datos de imagen 3D, el procedimiento comprende: identificar características del entorno en los datos de imagen 3D, siendo las características del entorno características en la imagen 3D fuera del objeto; y eliminar características del entorno de los datos de imagen 3D. 45. Procedimiento de visión artificial que comprende: capturar, utilizando un aparato de formación de imágenes bidimensionales (2D) , una imagen 2D de un objeto, identificar un código de barras del objeto en la imagen 2D, y determinar una o varias características de objeto tridimensional (3D) del objeto a partir del código de barras en la imagen 2D; capturar, utilizando un aparato de formación de imágenes tridimensionales (3D) del sistema de visión artificial, una imagen 3D de un entorno y almacenar datos de imagen 3D correspondientes a la imagen 3D; examinar los datos de imagen 3D para detectar una presencia de las una o varias características de objeto 3D; en respuesta a determinar que por lo menos una de las una o varias características de objeto 3D está ausente de los datos de imagen 3D, proporcionar una señal de detección de fallo digital a un usuario del sistema de visión artificial; y en respuesta a determinar que por lo menos una de las una o varias características de objeto 3D está presente en los datos de imagen 3D, cambiar por lo menos un parámetro sociado con el sistema de visión artificial. 46. Procedimiento de visión artificial, según la reivindicación 45, en el que determinar las una o varias características de objeto 3D del objeto a partir del código de barras en la imagen 2D comprende: descodificar el código de barras para generar datos de carga útil de código de barras y determinar la identificación del objeto a partir de los datos de carga útil de código de barras; y determinar, a partir de la identificación del objeto, las una o varias características de objeto 3D del objeto. 47. Procedimiento de visión artificial, según la reivindicación 45, en el que determinar las una o varias características de objeto 3D del objeto a partir del código de barras en la imagen 2D comprende: determinar una orientación del objeto a partir de una ubicación del código de barras en la imagen 2D; y determinar, a partir de la orientación del objeto, las una o varias características de objeto 3D como un subconjunto de características de objeto 3D disponibles. 48. Procedimiento de visión artificial, según la reivindicación 45, en el que las una o varias características de objeto 3D son por lo menos una de una característica dimensional y una característica de forma. 49. Procedimiento de visión artificial, según la reivindicación 45, en el que cambiar por lo menos un parámetro asociado con el sistema de visión artificial comprende cambiar un tiempo de exposición de un aparato de formación de imágenes 2D del sistema de visión artificial, una duración de pulso de iluminación de un conjunto de iluminación del sistema de visión artificial, una posición focal del aparato de formación de imágenes 2D del sistema de visión artificial, un nivel de ampliación de imágenes del aparato de formación de imágenes 2D, un brillo de iluminación, una longitud de onda de iluminación, o una fuente de iluminación del sistema de visión artificial. 50. Procedimiento de visión artificial, según la reivindicación 49, en el que la fuente de iluminación es una fuente de iluminación difusa o una fuente de iluminación directa. 51. Procedimiento de visión artificial, según la reivindicación 49, en el que cambiar la fuente de iluminación comprende cambiar de una fuente de iluminación que emite a una primera longitud de onda a una fuente de iluminación que emite a una segunda longitud de onda, diferente de la primera longitud de onda. 52. Estación de escaneado, que comprende: un aparato de formación de imágenes bidimensionales (2D) configurado para: capturar una imagen 2D de un objeto en un campo de visión (FOV) del aparato de formación de imágenes 2D; identificar un código de barras en la imagen 2D; e identificar el objeto a partir de una carga útil de código de barras; un aparato de formación de imágenes 3D configurado para: capturar una imagen 3D del objeto en un FOV del aparato de formación de imágenes 3D; y generar datos de imagen 3D a partir de la imagen 3D; y un procesador y una memoria que almacena instrucciones que, cuando se ejecutan, hacen que el procesador: identifique una o varias características de objeto 3D partir de los datos de imagen 3D; evalúe las una o varias características de objeto 3D con respecto a una identidad del objeto; y en respuesta a evaluar las una o varias características de objeto 3D con respecto a la identidad del objeto, ajuste un parámetro de funcionamiento de la estación de escaneado. 53. Estación de escaneado, según la reivindicación 52, en la que los datos de imagen 3D comprenden datos de nube de puntos 3D y las una o varias características de objeto 3D comprenden por lo menos una de características geométricas del objeto, color del objeto, gradación de color del objeto. 54. Estación de escaneado, según la reivindicación 52, en la que los datos de imagen 3D omprenden datos de nube de puntos 3D y las una o varias características de objeto 3D comprenden una posición del objeto en el FOV del aparato de formación de imágenes 3D. 55. Estación de escaneado, según la reivindicación 54, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine si la posición del objeto en el FOV del aparato de formación de imágenes 3D está en un intervalo aceptable para capturar la imagen 2D del objeto utilizando el aparato de formación de imágenes 2D; y en respuesta a que la posición del objeto en el FOV del aparato de formación de imágenes 3D no está en el intervalo aceptable, se abstenga de capturar una imagen 2D subsiguiente por el aparato de formación de imágenes 2D, hasta que se cumpla una condición de liberación. 56. Estación de escaneado, según la reivindicación 52, en la que el parámetro de funcionamiento comprende por lo menos uno de una intensidad de iluminación de un aparato de iluminación en el aparato de formación de imágenes 2D, un FOV del aparato de formación de imágenes 2D y una distancia focal del aparato de formación de imágenes 2D. 57. Estación de escaneado, según la reivindicación 52, en la que la estación de escaneado es un escáner bióptico que tiene una parte de torre y una parte de plato. 58. Estación de escaneado, según la reivindicación 57, en la que el aparato de formación de imágenes 3D es uno de la parte de torre y la parte de plato, y el aparato de formación de imágenes 2D está en la otra de la parte de torre y la parte de plato. 59. Estación de escaneado, según la reivindicación 57, en la que el aparato de formación de imágenes 3D y el aparato de formación de imágenes 2D están ambos en una de la parte de torre y la parte de plato. 60. Estación de escaneado, según la reivindicación 57, que comprende, además, un plato de peso dentro de la parte de plato, estando configurado el plato de peso para medir, mediante un módulo de pesaje, un peso de un objeto colocado en el plato de peso, teniendo el plato de peso una superficie de pesaje, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine, a partir de los datos de imagen 3D, una posición del objeto relativa al plato de peso;y en respuesta a que la posición del objeto relativa al plato de peso esté en una posición de fallo de plato de peso, modifique el funcionamiento del módulo de pesaje de un primer estado a un segundo estado, hasta que se cumpla una condición de liberación. 61. Estación de escaneado, según la reivindicación 60, en la que el primer estado del módulo de pesaje permite informar del peso del objeto colocado en el plato de peso, y en la que el segundo estado del módulo de pesaje impide informar del peso del objeto colocado en el plato de peso. 62. Estación de escaneado, según la reivindicación 60, en la que la posición de fallo de plato de peso comprende una posición sobresaliente, donde por lo menos una parte del objeto sobresale del plato de peso. 63. Estación de escaneado, según la reivindicación 60, en la que la posición de fallo de plato de peso comprende una posición suspendida, donde el objeto está suspendido, por lo menos parcialmente, sobre el plato de peso. 64. Estación de escaneado, según la reivindicación 52, que comprende, además, un plato de peso dentro de la parte de plato, estando configurado el plato de peso para medir, mediante un módulo de pesaje, un peso de un objeto colocado en el plato de peso, teniendo el plato de peso una superficie de pesaje, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: detecte, a partir de los datos de imagen 3D, que una mano del operario está en contacto con el objeto; y en respuesta a una detección de que la mano del operario está en contacto con el objeto, modifique el funcionamiento del módulo de pesaje de un primer estado a un segundo estado, hasta que se cumpla una condición de liberación. 65. Estación de escaneado, que comprende: un aparato de formación de imágenes 2D configurado para capturar una imagen 2D de un objeto en un campo de visión del aparato de formación de imágenes 2D y generar datos de imagen 2D a partir de la imagen 2D; un aparato de formación de imágenes 3D configurado para capturar una imagen 3D del objeto en un campo de visión del aparato de formación de imágenes 3D y generar datos de imagen 3D a partir de la imagen 3D; y un procesador y una memoria que almacena instrucciones que, cuando se ejecutan, hacen que el procesador: compare los datos de imagen 3D con los datos de imagen 2D y lleve a cabo un proceso de autenticación en el objeto. 66. Estación de escaneado, según la reivindicación 65, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine una primera identificación de objeto del objeto utilizando los datos de imagen 2D; determine una segunda identificación de objeto del objeto utilizando los datos de imagen 3D; y compare la primera identificación del objeto con la segunda identificación del objeto y determine (a) un escaneado apropiado del objeto cuando la primera identificación del objeto coincide con la segunda identificación del objeto y (b) un escaneado inapropiado del objeto cuando la primera identificación del objeto no coincide con la segunda identificación del objeto. 67. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador determine la primera identificación de objeto del objeto utilizando los datos de imagen 2D, mediante: identificar un código de barras para el objeto en los datos de imagen 2D; y descodificar el código de barras para generar datos de carga útil de código de barras y determinar la primera identificación del objeto a partir de los datos de carga útil de código de barras. 68. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, demás, instrucciones que, cuando se ejecutan, hacen que el procesador determine la primera identificación de objeto del objeto utilizando los datos de imagen 2D, mediante: proporcionar los datos de imagen 2D a un modelo de reconocimiento de objetos entrenado; y producir, utilizando el modelo de reconocimiento de objetos entrenado, la primera identificación de objeto del objeto. 69. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador determine la segunda identificación de objeto del objeto utilizando los datos de imagen 3D, mediante: proporcionar los datos de imagen 3D a un modelo de reconocimiento de objetos entrenado; y producir, utilizando el modelo de reconocimiento de objetos entrenado, la segunda identificación de objeto del objeto. 70. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador, antes de determinar la primera identificación de objeto del objeto utilizando los datos de imagen 2D: compare los datos de imagen 3D con los datos de imagen 2D; y elimine características del entorno fuera del objeto de los datos de imagen 2D basándose en los datos de imagen 3D. 71. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador, antes de determinar la segunda identificación de objeto del objeto utilizando los datos de imagen 3D: compare los datos de imagen 3D con los datos de imagen 2D; y elimine características del entorno fuera del objeto de los datos de imagen 3D basándose en los datos de imagen 2D. 72. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, demás, instrucciones que, cuando se ejecutan, hacen que el procesador determine la segunda identificación de objeto del objeto utilizando los datos de imagen 3D, mediante: determinar una o varias características de color del objeto a partir de los datos de imagen 3D; y determinar la segunda identificación del objeto a partir de las una o varias características de color. 73. Estación de escaneado, según la reivindicación 72, en la que las una o varias características de color comprenden un color del objeto. 74. Estación de escaneado, según la reivindicación 72, en la que las una o varias características de color comprenden un gradiente de color del objeto. 75. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador determine la segunda identificación de objeto del objeto utilizando los datos de imagen 3D, mediante: determinar una o varias características geométricas del objeto a partir de los datos de imagen 3D; y determinar la segunda identificación del objeto a partir de las una o varias características geométricas. 76. Estación de escaneado, según la reivindicación 75, en la que determinar la primera identificación de objeto del objeto utilizando los datos de imagen 2D comprende: identificar un código de barras para el objeto en los datos de imagen 2D; y descodificar el código de barras para generar datos de carga útil de código de barras y determinar la primera identificación del objeto a partir de los datos de carga útil de código de barras. 77. Estación de escaneado, según la reivindicación 76, en la que los datos de imagen 3D incluyen una nube de puntos que comprende una pluralidad de puntos de datos, teniendo cada uno de los puntos de datos un valor de distancia asociado con una distancia desde el aparato de formación de imágenes 3D, y en el que determinar las una o varias características geométricas del objeto a partir de los atos de imagen 3D se basa en un primer subconjunto de los datos de imagen 3D y no se basa en un segundo subconjunto de los datos de imagen 3D, estando asociado el primer subconjunto de los datos de imagen 3D con un primer subconjunto de los puntos de datos que tienen el valor de distancia respectivo asociado con la distancia desde el aparato de formación de imágenes 3D dentro de un intervalo predeterminado, estando asociado el segundo subconjunto de los datos de imagen 3D con un segundo subconjunto de los puntos de datos que tienen el valor de distancia respectivo asociado con la distancia desde el aparato de formación de imágenes 3D fuera del intervalo predeterminado. 78. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador, en respuesta a determinar (a) el escaneado apropiado del objeto, procese un registro de transacciones para incluir los datos asociados con el objeto, y en respuesta a determinar (b) el escaneado inapropiado del objeto, por lo menos uno de (i) genere una alerta adecuada para señalizar un potencial evento de robo, y (ii) procese el registro de transacciones para no incluir los datos asociados con el objeto. 79. Estación de escaneado, según la reivindicación 66, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine, a partir de los datos de imagen 3D, una dirección de escaneado del objeto relativa al aparato de formación de imágenes 2D; y en respuesta a que la dirección de escaneado es una dirección de escaneado inapropiada, impida la captura de la imagen 2D por el aparato de formación de imágenes 2D, hasta que se cumpla una condición de liberación. 80. Estación de escaneado, según la reivindicación 65, en la que el objeto es un producto, y en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine, como una primera identificación de objeto del objeto utilizando los datos de imagen 2D, uno o varios colores del objeto; determine, como una segunda identificación de objeto del objeto utilizando los datos de imagen 3D, una forma o dimensión del objeto; y compare la primera identificación del objeto con la segunda identificación del objeto y etermine un tipo del producto. 81. Estación de escaneado, según la reivindicación 65, en la que el objeto es un producto, y en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine, como una primera identificación de objeto del objeto utilizando los datos de imagen 2D, uno o varios colores del objeto; determine, como una segunda identificación de objeto del objeto utilizando los datos de imagen 3D, una forma o dimensión del objeto; y compare la primera identificación del objeto con la segunda identificación del objeto y determine un listado de tipos potenciales del producto; y presente el listado a un usuario de la estación de escaneado para su selección. 82. Estación de escaneado, según la reivindicación 65, en la que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: determine, como una primera identificación de objeto del objeto utilizando los datos de imagen 2D, una presencia de un código de barras parcialmente descodificable y determine un listado de coincidencias de objeto potenciales a partir del código de barras parcialmente descodificable; determine, como una segunda identificación de objeto del objeto utilizando los datos de imagen 3D, una forma o dimensión del objeto; y compare la primera identificación del objeto con la segunda identificación del objeto y determine si una o varias del listado de coincidencias de objeto potenciales corresponden a la forma o a la dimensión indicadas en la segunda identificación del objeto a partir de los datos de imagen 3D. 83. Estación de escaneado, que comprende: un aparato de formación de imágenes bidimensionales (2D) configurado para capturar una imagen 2D de un objeto en un campo de visión (FOV) del aparato de formación de imágenes 2D y para identificar un código de barras en la imagen 2D para identificar el objeto a partir de la carga útil de código de barras; un aparato de formación de imágenes 3D configurado para capturar una imagen 3D del objeto en un FOV del aparato de formación de imágenes 3D y generar datos de imagen 3D a partir de la imagen 3D; y un procesador y una memoria que almacena instrucciones que, cuando se ejecutan, hacen que el procesador: capture la imagen 3D del objeto y genere los datos de imagen 3D; identifique una o varias características de objeto 3D del objeto a partir de los datos de imagen 3D; y lleve a cabo uno de (a) entrenar un modelo de reconocimiento de objetos con los datos de imagen 3D, o (b) reconocimiento de objetos utilizando los datos de imagen 3D. 84. Sistema, que comprende: un aparato de formación de imágenes bidimensionales (2D) que tiene un primer campo de visión (FOV) y está configurado para capturar una imagen 2D de un primer entorno que aparece dentro del primer FOV, almacenándose la imagen 2D como datos de imagen 2D correspondientes a la imagen 2D; un aparato de formación de imágenes tridimensionales (3D) que tiene un segundo FOV que se superpone por lo menos parcialmente con el primer FOV, estando configurado el aparato de formación de imágenes 3D para capturar una imagen 3D de un segundo entorno que aparece dentro del segundo FOV, almacenándose la imagen 3D como datos de imagen 3D correspondientes a la imagen 3D; y un procesador y una memoria que almacena instrucciones que, cuando se ejecutan, hacen que el procesador: identifique una o varias características de imagen 3D dentro del segundo entorno a partir de los datos de imagen 3D; mejore los datos de imagen 2D, dando como resultado datos de imagen 2D mejorados, mediante correlacionar las una o varias características de imagen 3D con por lo menos una o varias características de imagen 2D en los datos de imagen 2D; y procese los datos de imagen 2D mejorados para por lo menos uno de (a) descodificar un código de barras capturado dentro de los datos de imagen 2D mejorados, (b) entrenar un modelo de reconocimiento de objetos con los datos de imagen 2D mejorados, (c) reconocer un objeto dentro de los datos de imagen 2D mejorados, y (d) identificar una acción llevada a cabo por un operario del lector de códigos de barras. 85. Sistema, según la reivindicación 84, en el que los datos de imagen 3D comprenden atos de nube de puntos 3D y las una o varias características de imagen 3D incluyen una o varias características geométricas de un objeto presentado dentro del segundo FOV. 86. Sistema, según la reivindicación 84, en el que los datos de imagen 3D comprenden datos de nube de puntos 3D y las una o varias características de imagen 3D incluyen un color o una gradación de color correspondientes a un objeto presentado dentro del segundo FOV. 87. Sistema, según la reivindicación 84, en el que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador identifique las una o varias características de imagen 3D identificando las una o varias características de imagen 3D que están posicionadas dentro de un intervalo de distancia predeterminado fuera del aparato de formación de imágenes 3D. 88. Sistema, según la reivindicación 87, en el que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador mejore los datos de imagen 2D filtrando las por lo menos una o varias características de imagen 2D de modo que procesar los datos de imagen 2D mejorados excluye procesar datos de imagen asociados con las por lo menos una o varias características de imagen 2D. 89. Sistema, según la reivindicación 87, en el que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador mejore los datos de imagen 2D filtrando las por lo menos una o varias características de imagen 2D de modo que procesar los datos de imagen 2D mejorados se limita a procesar los datos de imagen asociados con las por lo menos una o varias características de imagen 2D. 90. Sistema, según la reivindicación 87, que comprende, además, un lector de códigos de barras estacionario configurado para ser posicionado dentro de una estación de trabajo y manejado por el operario, en el que el intervalo de distancia predeterminado fuera del aparato de formación de imágenes 3D se extiende desde el aparato de formación de imágenes 3D hasta un borde de la estación de trabajo próximo al operario. 91. Sistema, según la reivindicación 87, que comprende, además, un lector de códigos de barras bióptico que tiene una zona de escaneado de producto, en el que el intervalo de distancia predeterminado fuera del aparato de formación de mágenes 3D se extiende desde el aparato de formación de imágenes 3D hasta el límite distal de la zona de escaneado de producto. 92. Sistema, según la reivindicación 84, en el que las una o varias características de imagen 3D incluyen por lo menos una de (i) por lo menos una parte de una mano del operario, y (ii) un objeto agarrado por la mano del operario. 93. Sistema, según la reivindicación 84, en el que la memoria almacena, además, instrucciones que, cuando se ejecutan, hacen que el procesador: procese los datos de imagen 2D mejorados identificando la acción llevada a cabo por el operario; en respuesta a identificar la acción llevada a cabo por el operario como una de presentar un objeto dentro de una zona de escaneado de producto y presentar el objeto próximo a la zona de escaneado de producto y, en respuesta, además, a que no se detecta ningún código de barras dentro de por lo menos uno de los datos de imagen 2D y los datos de imagen 2D mejorados, genere una alerta adecuada para señalizar un potencial evento de robo.

Los productos y servicios protegidos por este registro son:

G06K 19/00

Descripciones: